“这边建议重写呢~”

当听到好友给出这样的评价时,那一瞬间,李飞飞内心是崩塌的。

2019年,人工智能科学家李飞飞与自己的哲学家好朋友约翰·埃切门迪,共同成立了斯坦福大学以人为本人工智能研究院(HAI),旨在推动人工智能技术的发展的同时,确保这些强大的工具能够服务于提升人类福祉,而非仅仅追求生产力的提高。

当时,有出版社邀请李飞飞撰写一本关于AI的科普书,这对于李飞飞来说不算是难事儿,她就按照传统科普的思路深入浅出地介绍了一下人工智能,没想到好朋友兼合伙人埃切门迪看完之后,直接建议她重写——

“其实你有一段独特的历程,代表了很多觉得自己在AI领域没有发言权,或找不到认同感的人……如果你能给他们一个声音,这将更有力量。”

图1. 人工智能科学家李飞飞

现在的李飞飞,是拥有20年AI经验的,荣誉满身的世界级人工智能科学家。她入选《Times》推出的“全球100位AI人物”,还是美国国家工程院院士、美国国家医学院院士和美国艺术与科学院院士。她被硅谷称为“AI教母”,2009年,她主持创立的ImageNet系统公布,为AI发展提供土壤。去年年底,又带领团队与谷歌合作,推出AI视频生成模型W.A.L.T。

图2. 《Times》“全球100位AI人物”

在另一个视角上,她内心里则永远住着一个来自中国四川的、爱跳舞的小女孩。她16岁跟随母亲离开家乡四川,移民美国,在整个青少年时期,为了应对拮据的生活,她不但要在餐厅刷盘子,还要去妈妈的干洗店帮工,那时的她,其实并没有太多机会接触计算机,“更没有成为科学家的奢望”。

图3. 幼年时的李飞飞与父母

“人工智能不是现象,不是颠覆,不是难题,也不是特权。我们面对的是一种自然力量。它是如此宏伟强大,又如此反复无常;既能轻易激发灵感,也很容易摧毁一切。要让人工智能值得信任,需要的远不止商业公司空洞的陈词滥调……所以我们不要被那些时髦的术语吓到,不要迷茫于AI时代自己的角色。只要把AI当成一个工具,人类不仅是工具的创造者,我们也是如何使用工具的决策者。”

受到埃切门迪的启发,在不久前的全球技术大会(GTC)上,李飞飞从更宽广的视角分享了对于AI的差异化观点。尤其是她从人类智能在自然界的进化历程作为参照,来分析AI更有可能的未来走向。

本期【朋克金融学】,将从第一人称视角,提炼并简述李飞飞的几个核心观点。

01

智能在自然界的进化始于对世界的感知。AI的进化,特别是深度学习的历史,一直与计算机视觉这个领域的进化紧密交织在一起……因为从根本上说,语言是一个一维结构。而视觉从根本上是三维的。如果加上时间,就是四维的。三维结构要丰富得多,但也复杂得多。

最终理想的模型是感知的,超越语言互动的模型,只有能掌握人类在5.4亿年的时间里形成的那些细微的,比文字更人性的感知,AI才算有了基础模型。

脑补一下:5亿4300万年前,地球尚未进化成为视觉的世界。

在三叶虫出现之前,所有生物吃饭全靠撞大运。

运气好的时候,老天爷亲自赏饭送到嘴里;运气不好的时候,吃了上顿没下顿。

生物没得可看,没得可听,没得可摸,收集不到信息,也就意味着没什么处理信息的必要。

换句话说,它们没有脑子。

图4. “中国古生物”系列邮票之“嵩里山三叶虫”

直到拥有了光的视觉感知。

寒武纪大爆发是进化秩序中一次猛烈的洗牌。

受动物学家安德鲁·帕克的启发——引发寒武纪大爆发的导火索不是外来力量,而是内在力量。

帕克认为,这种内在力量,其实是某种单一能力的出现,这种能力,就是光敏感性,或者说,现代眼睛的基础。

光的视觉感知打响了进化军备竞赛的第一枪,让我们不严谨地捋一捋这个进化的过程:

■ 生物们慢慢变得能看到东西了——不用再嗷嗷待哺,给啥吃啥了,生物开始有能力主动追逐食物。

■ 随后触觉开始出现,与不断发展的视觉形成互补平衡——这个东西什么感觉,好不好抓。

■ 光信号、触觉信号等神经细胞相互连接,形成了“神经网”,有了“反射”——这个看上去好吃,哕!不好吃,下次不吃了。

■ 更加精密的视觉、触觉等感知,这也意味着被收集到的信息越来越复杂,需要被处理的信息也越来越复杂,而这些都指向同一个结果——要长脑子了。

视觉的出现,意味着生物第一次意识到世界存在着超越自身之外的东西,在只有大约一千万年的时间里,进化“一眨眼”,地球上的生命焕然一新。

随着“视野”范围和深度的扩展,行动可以在更广阔的范围展开,同时还要处理更多的不确定性,于是,思维不得不适应,发展出更强的智力,逐渐融入因果关系的意识、时间的流逝,甚至是操纵环境本身的效应。生物大脑,甚至人类的智慧在此基础上诞生。

由此我们可以看到,视觉无疑是最生动的组成部分。从去年各种AI模型在文字上带给我们的震撼,到年初以来在图像、视频领域上不断视觉冲击,如生物进化发展的历程一样,视觉工程在AI上的发展,很可能是人工智能的一大步。

02

视觉不仅仅是我们智力的一种应用,实际上,它与我们的智力同义。

我们再深入探讨一下。

“你有没有想过如何向一个色盲患者解释颜色?你会如何用言语描述看到红色的体验?”

“当我说‘蓝色’或‘红色’时,你可能知道我的意思,但那只是因为你自己已经见过这些颜色。我的话只是在唤起你的记忆;它们并没有传达新的信息。”

这是和计算神经科学家克里斯托夫·科赫的一次对话。

你有没有发现,我们对颜色的熟悉,似乎并没有转化为描述它的能力。

这不是很奇怪吗?

于是,问题来了,我们都无法描述颜色,又怎么教会机器呢?

在数字世界搜一个字,查一句话,这自计算机诞生以来就可以做到,但很长一段时间里,即使是对图像的粗略搜索也是一项手动工作。

想给机器点颜色看看?同时满足“查言阅色”?机器做不到啊。

【释义】形容机器又可以检索文字,也可以阅读理解图像。

数字图像以像素的形式存储,在机器看来,图像不过是一个长长的整数列表。而对于人来说,尽管我们仅仅从落在眼睛表面的光来看世界,但从光中得到的信息会快速填满我们整个体验的全部。

我们毫不费力地掐眼一撇,就可以得出并理解大量信息,这是人类5亿4300万年努力进化的结果,而机器要像人类那样,以人、地点和事物等有意义的概念去“看到”图像,算法必须筛选图像这个长长的整数列表,并识别出某种相对应的数字模式。

再深入探讨一下,如何将“被动的看的行为”和“更深层次的理解的行为”区分开来?事实上,两者是无法分离的——看就是理解,这个挑战既是智力上的,也是感官上的。视觉不仅仅是智力的一种应用,实际上,它与我们的智力同义。

03

AI最终理想的模型很可能是感知的,超越语言的,是可以互动的模型。人类在5.4亿年漫长岁月中形成的“感知大脑”,比几十万年就发展成的“语言大脑”,更加细腻,此时AI才算有了基础模型。

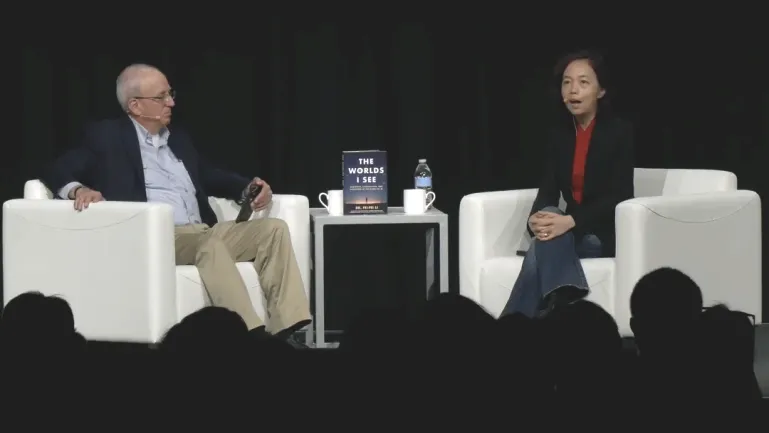

最后,我们引用英伟达首席科学家Bill Dally与李飞飞在GTC的一段炉边对话,来描述真正的人工智能可能演化的方向。

图5. 英伟达炉边谈话(左:英伟达首席科学家Bill Dally;右:李飞飞)

李飞飞

我有点嫉妒我那些搞NLP*的同事,因为从根本上说,语言是一个一维结构。而我从事视觉工作,它本质上是三维的,如果再加上时间,那就是四维的。三维结构要丰富得多,但也复杂得多。

所以当我们用大数据进行扩展时,如果是完全盲目的扩展,那么我想英伟达会很高兴,你们会卖出更多芯片。但我想看到的是结构化建模,或者说偏向于三维感知和结构的模型与大数据相结合。我认为,要真正创造出空间智能。我们今天仍然缺乏的真正的世界模型,它在等待着被创造出来。

*NLP:NLP是神经语言程序学(Neuro-Linguistic Programming)的英文缩写。N(Neuro)指的是神经系统,包括大脑和思维过程;L(Linguistic)是指语言,是指从感觉信号的输入到构成意思的过程;P(Programming)是指为产生某种后果而要执行的一套具体指令。

Bill Dally

你是在暗示类似于许多类型科学模拟中使用的物理信息神经网络,你会扩展到利用人类对世界的先验知识,用它来使这些世界模型更有效?

李飞飞

是的,物理学就是对动力学和结构的信息输入及推导。

Bill Dally

那么你认为基础模型会出现在世界层面吗?也就是说我们可以问它任何关于世界的问题,而它会以多模态四维格式回答我们?

李飞飞

我确实认为基础模型会出现在世界层面。我认为你不需要只是问它问题,这是一种以语言为中心的交互方式,实际上你应该可以与它互动。看看人类,或者生物体,作为一个计算机视觉人,我想提醒大家一件事,自然花了5.4亿年的时间来创造“感知大脑”。而创造“语言大脑”只花了几十万年。所以感知是非常非常深刻的。

参考资料:

《The World I See》 [美]李飞飞

Fireside Chat With Fei-Fei Li and Bill Dally: The High-Speed Revolution in AI and Managing the Impact on Humanity [S61069] 来源: nvidia.com

泉果博物馆

装置艺术作品

2018年

美国 黑石城 火人节

该作品被命名为Lodestar(北极星),由一架古老的军用喷气式飞机改装,顶部则是一个供火人们聚会的派对空间,在日落时分,很多火人会登上Lodestar,俯瞰整个笼罩在夕阳余晖中的黑石城。

李飞飞不只一次,把自己所追求的人工智能的终极科学目标,形容为北极星。她说:“我想,北极星真正的价值不仅在于指引,还在于我永远追不上它。所以,我反而可以用一生去追求它,而科学家最独特的特征,恰恰就是有一颗永远无法被满足的好奇心……夜晚的星星,远处的海市蜃楼,一条没有尽头的路。我意识到,这就是人工智能对我的意义。”

2024-03-29 08: 46

2024-03-28 19: 08

2024-03-28 19: 08

2024-03-28 17: 24

2024-03-28 17: 19

2024-03-28 17: 15