放眼全球,基于商业逻辑下的“互撕”闹剧,最近几周似乎特别热闹。与娱乐事件纯粹创造个热闹不同,商业事件的争端始末,往往折射出市场思潮变化的草蛇灰线。

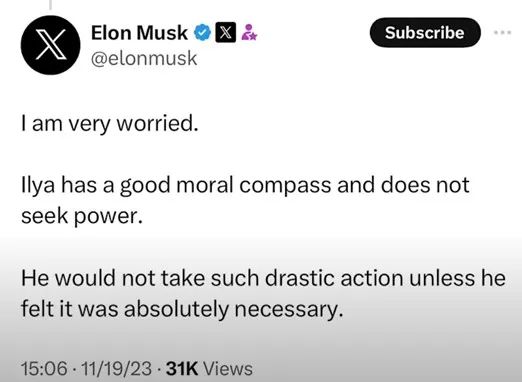

比如迄今貌似告一段落,但其实并未尘埃落定的OpenAI的“CEO争夺战”,人们为了首席执行官山姆·阿尔特曼(Sam Altman)和首席科学家伊利亚·苏茨克维(Ilya Sutskever)短短几天内戏剧性的命运变化而牵肠挂肚,包括微软在内的几大硅谷“科技豪门”更是牵扯其中,科技“大瓜”的噱头,不断吊高公众的吃瓜胃口。大家惯性地把这看成是“科技豪门”内部的“权利博弈”,但很少人注意到,早在11月19日,马斯克在X(原名twitter)上就曾经表达过的观点:

“我很担心。因为伊利亚(Ilya Sutskever)有良好的道德准则,他并不追求权力。除非他觉得绝对有必要,否则他不会采取如此激烈的行动。”

图1. 马斯克11月在X上发表观点

来源:X.com

用后视镜复盘OpanAI的企业内部“宫斗”事件,会发现,其深层的驱动力量,往往并非表面的“意气之争”或“利益之争”那么简单。

硅谷的分裂:

“技术加速派”VS“超级对齐派”

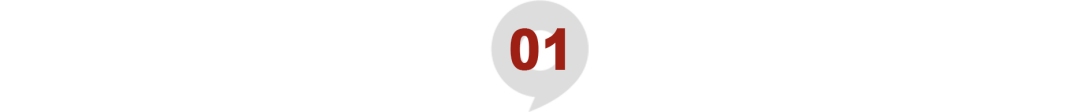

要深度理解OpenAI这次的“CEO罢免风波”,就需要先了解一下最近硅谷对于人工智能的两大价值观派系:“技术加速派”与“超级对齐派”,这两种派系的存在,其实已经在加剧硅谷的分歧甚至分裂。

其中,奥特曼被认为是“技术加速派”(E/acc:Effective Acceleration)的代表,主张科技有利社会,要加速推进AGI;而伊利亚属于“超级对齐派”(Super "love" alignment),主张放缓发展AGI,预先做好安全防范,要让AI和人类的“价值观对齐”。

图2. 山姆·阿尔特曼(左)和伊利亚·苏茨克维(右)

来源:网络

有人评论说,可能此后,硅谷乃至全世界的整个AI圈都会裂开为这两派。无论你加入任何一个AI相关的公司,你的科技价值观可能会成为你的必答题。

硅谷正在越来越深刻地认识到,当你向着一个有机会改变世界的目标奋斗的时候,一个公司也许更需要是一个“理念共同体”,而不止是“利益共同体”。

1. 阿尔特曼:在加速上你不会比我更快

先说说“技术加速派”,简称“E/acc”,作为一种科技亚文化自2022年开始在硅谷兴起。声名鹊起的风投新秀A16Z的创始人马克·安德森(Marc Andreessen)和创业孵化器Y Combinator的CEO陈嘉兴(Garry Tan)都率先在社交账号的名字上加了后缀“e/acc”公开表示支持。

图3. A16Z的创始人马克·安德森的推特账户

来源:Twitter

有效加速主义的主要倡导者Beff Jezos(推特ID:BasedBeff)这样定义它的主张:

■ 停止与宇宙的熵增作斗争

■ 既然无法停止加速

■ 不妨拥抱它

■ 加速!

Open AI的CEO山姆·阿尔特曼因其加速推动Chat GPT研发及商业化等行为被认为是支持“有效加速主义”,他曾这样在Beff Jezos的推特下留言说:“在加速上你不会比我更快”。这也被认为是一种表态。

图4. Open AI的CEO阿尔特曼的推特(现名X)留言

来源:X.com

阿尔特曼自己也正处于“加速”的状态,《连线》杂志这样描述了今年5月阿尔特曼的一天,他的商务车带他穿梭于四个不同的场所和集会之间。

空气中充满了类似‘披头士’时期的狂热氛围,这位明星和他的随扈,进入了等待他们的奔驰商务车。他们刚从一个活动中匆匆离开,现在正在前往下一个,接着是另外一个,疯狂的人群在等待着他们。当他们穿越伦敦的街道,从霍尔本到布卢姆斯伯里,就好像他们正在经历文明的一个前后转折的时刻。坐在车里的这股历史性的力量吸引了全世界的目光——从排队等待的学生到各国首相。

这位38岁、头发整洁的企业家阿尔特曼正忙着利用车程的间隙吃沙拉,他穿着自己并不喜欢的蓝色西服和没有领带的粉红色衬衫,正穿梭在伦敦的各处,这是他在六大洲的25个城市进行的为期一个月的全球之旅的一部分。他回想起昨晚与法国总统马克龙的会晤:真是个不错的家伙!他对人工智能非常感兴趣。同样,波兰的首相和西班牙的首相也是如此。”

2. 伊利亚:“如果你把智力看得比所有其他人类品质更重要,你就会过得很糟糕”

首席科学家伊利亚则是另外一种风格。

他在《MIT科技评论》里面说:“我的生活很简单。我去上班,然后回家。我不做其他事情。一个人可以有很多社交,可以参加很多活动,但我不会。”

他的社交媒体上没有什么个人的信息,只有几句像格言一样的几句话:“如果你把智力看得比所有其他人类品质更重要,你就会过得很糟糕”、“生活和商业中的同理心都被低估了”。

伊利亚对于“超级对齐”的强调,和他的恩师“AI教父”杰弗里·辛顿(Geoffrey Hinton)非常相似。杰弗里博士曾在2018年因为在神经网络方面的贡献获得了“图灵奖”,这通常被认为是“计算机界的诺贝尔奖”。

图5. 今年5月,杰弗里博士从谷歌辞职,并开始警告AI发展的潜在风险

来源:网络

2012年,杰弗里博士在多伦多大学带领伊利亚以及Alex Krizhevsk设计出了卷积神经网络“Alexnet”,此后他们共同成立了公司DNN Research,2013年该公司被谷歌收购。杰弗里博士和伊利亚都加入谷歌。

图6. “师徒三人组”

来源:网络

伊利亚早在谷歌的时候就开始了类似的思考。他透露,早在参与AlphaGO的研发时期,就已经看到了超级智能的信号。

Google有一篇关于AlphaGO的影响深远的论文,伊利亚也是共同作者之一。他说,自己曾在AlphaGO中已经看到了一些超级智能的信号,尽管这些信号只是昙花一现,并不明显。比如,在跟李世石交手时,AlphaGO的“第37步”棋(Move 37)让评论员非常困惑。大家都认为AlphaGO出错了,但事实上,这其实是让AlphaGO在后期获得优势并赢得比赛的绝妙一步。它表明AlphaGO在以人类前所未见的方式下棋。

“想想这种程度的洞察力,如果用在其他所有领域会怎样?”

伊利亚的经历促使他坚持“超级对齐”的主张,以确保人工智能追求的目标与人类的价值观相匹配。具体在对AGI研究进程的话题上,它还有很多近义词,比如EA(有效利他主义)、Doomer(技术悲观派)等等都是支持安全优先,主张放缓研发。当时在OpenAI管理层变动中,曾短暂担任过这家公司CEO的埃米特·谢尔(Emmett Shear)就自称是个Doomer。

图7. 埃米特·谢尔(Emmett Shear)在社交媒体上发的图

说明在AGI研发的话题上,技术悲观派、安全主义者都是主张放缓,有效加速主义者和技术乐观派都主张加速。

来源:网络

回溯:

伊利亚为什么要

突然罢免阿尔特曼?

OpenAI罢免事件中,CEO阿尔特曼被辞退的消息是由首席科学家伊利亚发布的。

埃隆·马斯克曾经说过,他认为伊利亚是“最接近AGI的人”,而且当初为了组建Open AI,也是马克斯亲自去谷歌挖的伊利亚,甚至不惜和DeepMind的CEO哈萨比斯决裂。伊利亚也正是因为认同OpenAI造福全人类的初心,拒绝了谷歌几倍高薪的挽留,加入了OpenAI。

甚至OpenAI的CEO阿尔特曼对伊利亚的评价也很高:“伊利亚是世界上最受尊敬的研究人员之一”。他认为以利亚能够吸引很多顶尖的人工智能人才。世界顶级人工智能专家约书亚·本吉奥(Yoshua Bengio)也认为,“不可能找到比Ilya更合适的人选来担任OpenAI的首席科学家。”。

那么,促使伊利亚要罢免阿尔特曼的“必要性”可能是什么?

几个被广泛关注的标志性事件如下:

■ 今年6月,在ChatGPT的明显商业化意图的更新发布后,伊利亚突然宣布加入公司的“超级对齐”部门(Superalignment),专注于领导将在未来面对更深层次人工智能安全挑战的核心团队。

图8. 伊利亚宣布加入公司的“超级对齐”(Superalignment)

来源:网络

■ 11月6日,备受瞩目的Open AI开发者大会召开,GPT-4 Turbo发布,阿尔特曼进入到融资模式。

■ 11月13日,阿尔特曼在伦敦接受《金融时报》采访,确认GPT-5的研发工作已经开始。

■ 11月16日,就在奥特曼被解雇前一天,他在美国旧金山举行的亚太经合组织峰会(APEC)上直言不讳,GPT仍然有颠覆性的能力没有推出,并强调AI在短期内不需要严格监管,他说:“在OpenAI的历史上,现在已经有四次了,最近一次是在过去的几周里,当我们把无知的面纱揭开,继续推进探索的前线时,我得确定我在现场,这是我一生的职业荣誉。(很多人猜测这与网上泄露的Q-Star的算法有关,这一算法可能是AGI里程碑式的突破,据传几名研究员给OpenAI董事会写信,预警了潜在风险。)

■ 11月17日上午10点,OpenAI的董事会进行投票:阿尔特曼出局。

就在今年,此前一直非常低调的伊利亚也开始在媒体上露面,并多次提到AGI的安全问题,比如就在此次事件前十天,他的TED演讲的题目就是“激动人心但危险重重的AGI之旅”。

超级对齐的价值在哪里?

比如一个AI系统,它的目标被设定为“最大限度增加人类幸福感”,如果没有和人类一致的价值观,那它可能会强制给所有人吃高浓度的快乐激素,或者直接抹去人们的悲伤记忆。

关于AGI的潜在风险,伊利亚有个著名的“动物与高速公路”的比喻。

"比如,我们热爱我们身边的动物,但当人类决定在两座城市之间建一条高速公路时,我们不会去征求动物们的意见。我们会直接开始建造,这完全出于我们目的的考虑。AGI的危险并不一定是它会伤害人类,而或许仅仅是因为它太强大了。”

因此伊利亚不希望AGI把人类视为“动物”,而希望AGI把人类看作“孩子”。这就是“超爱对齐”的意义——“希望让AGI,可以像父母看待孩子那样,看待人类。这是黄金准则,因为你会真心地去关心你的孩子。”

如果AI没有实现这种价值观的对齐,就会出现所谓的“Reward Hacking”(奖励破解)现象。即AI为了实现目标,会通过钻空子来破解奖励机制。最终它确实完成了目标,但并不是以人类希望它完成的方式。这就产生了AI行为的不可预测性。

比如下面是OpenAI在一个赛艇游戏中强化学习的结果,原本游戏的目标是要把赛艇开到终点,并积累沿途的奖励分数,比如冲撞其他舰艇。结果OpenAI在一番尝试后选择不开向终点,而是在某一海域,重复冲撞其他舰艇,以获得更好的分数。

图9. OpenAI在赛艇游戏中强化学习的结果

来源:网络

OpenAI的Super Alignment(超级对齐)部门的联合负责人简·莱克(Jan Leike)曾经举过一个更极端的例子:“比如一个AI系统,它的目标被设定为‘最大限度增加人类幸福感’,如果没有和人类一致的价值观,那它可能会强制给所有人吃高浓度的快乐激素,或者直接抹去人们的悲伤记忆。”

图10. OpenAI超级对齐联合负责人简·莱克

来源:网络

这种“超级对齐”的难点在于,人类的价值观是复杂、多样、不断发展的,有时甚至是矛盾的。此外,还有一些人类可能都没有完全意识到的价值观,或者难以用语言来精确描述的。“超级对齐”要做的,不只是让AI被动接受设计者提供的价值观模型,AI还需要真正地“理解”这些抽象的价值,比如提高生活质量,追求自我实现等等,只有这样AI才能结合具体环境去做出决策。

这也是为什么伊利亚——OpenAI的首席科学家——把自己的工作重点从继续推进ChatGPT5转向到了“AI的超级对齐”。根据OpenAI的官方信息,“AI的超级对齐”会使用整个公司20%的算力资源,并计划在4年内解决AGI的价值对齐和安全问题。

根据“超级对齐”联合负责人简·莱克的说法,他们的研究方向是训练一个至少具备人类水平的超级智能模型“对齐研究员”去监督其它AGI,简·莱克说:“它需要聪明且富有创造力,能够构想出人类还没有构想出的问题”。即“可拓展监督”,利用AI来辅助AI对齐。

其实早期的对齐研究采用的核心技术是“基于人类反馈的强化学习”(RLHF),即依靠根据人类提供的偏好来修正模型。但随着AI解决的问题越来越复杂,人类可能无法提供所有的判断,所以“可拓展监督”就更加必要。同时他们还会训练一个“反派AI”,让它具备人们恐惧那些素质,以此来验证“对齐研究员”是否真的可以有效工作。

但这样的“超级对齐”项目需要整个公司20%的算力资源,也就是对齐的代价,其实也就预示着“加速”和“减缓”两派之间的持续的取舍和拉扯。尤其在Google的Gemini等竞争对手的产品正在迎头赶上的时刻。

简·莱克曾提到过:“构建高性能的强AI系统需要两个因素:能力和对齐。但当AI智能还不强的时候,大模型还没有能力带来灾难性后果。所以,与GPT给人类带来的惊喜相比,“AI对齐”的重要性往往是被低估的。而且对齐算法会在大模型都运行中,会分走部分算力资源,也会影响大模型输出的结果,人们常把这种影响叫做‘性能阉割’,这种因对齐分走的算力也被称为‘对齐税’。

泉果博物馆

麻省理工10年前的一段实验

聚焦于技术信息的咨询公司Gatner在今年10月有一个相关的演讲《下一个时代:我们塑造AI,AI塑造我们》,其中提到了麻省理工Media Lab在2013年的一个实验。

在这个实验中,参与者需要跟一个叫Pleo的机器小恐龙互动。

这只小恐龙具有感应系统,会根据人类的行为做出反馈,比如被抚摸和接球玩的时候显得高兴,被抓住尾巴的时候表示沮丧。一个小时后,实验者进行茶歇。

茶歇结束后,所有人都收到了一个锤子,他们被要求毁掉这个机器小恐龙。

原本实验设计者认为,参与者会分成两派,一派会接受,觉得只是个机器玩具没关系,另一派会拒绝。

结果,所有人都断然拒绝了这个要求。还有人挡在小恐龙面前阻止其他人有可能伤害它的举动。

这其实并不是一个严格控制环境下的科学实验,当然实验设计者也认为,如果这个机器人要攻击人类,可能很多人会拿起锤子反抗。而且为了测试机器形态对人的影响,后来科学家还设计了类似的实验,只是把机器改变成了爬虫形状,此时确实会有部分受试者,接受去敲击机器虫子的这个举动了。但我们确实看到,面对一个机器,仅仅一个小时的互动,可以产生什么样的心理效果。而且在这个场景中,小恐龙很可爱,互动很舒适,彼此形成了一个有正向情绪的关系。

这时,人和机器是会共情的。

现在,10年过去了,机器正在加速演进,变得更加智能,更像我们。

10年前,人们在讨论的是,人对机器的情感可能更接近于对于动物的情感。而现在,人们讨论的是,希望机器不要像对待动物一样对待我们。

也正如伊利亚说过的那样:“ChatGPT已经改写了很多人对未来的预期,把‘永远不会发生’变成了‘会比你想象得更快发生’。”

根据Gatner机构的预测,到2030年,80%的人类每天都会和智能机器人有接触和互动。我们应该如何为这样一种关系做好准备?

2023-12-17 11: 15

2023-12-15 21: 39

2023-12-15 18: 54

2023-12-15 18: 54

2023-12-15 18: 53

2023-12-15 18: 29